Europejska ustawa o AI wzorem dla reszty świata?

Cel

Sztuczna inteligencja może stać się dobrem wspólnym, jeśli osadzimy ją w ramach wiarygodnego i sprawiedliwego prawa. Użytkownicy oraz twórcy systemów AI potrzebują konkretów. Przy okazji przedsiębiorcy powinni mieć wsparcie finansowe.

Pakiet środków, nad którym pracuje UE, ma wspierać rozwój AI, uwzględniając innowacje i bazując na skoordynowanym planie. Priorytetem jest zapewnienie bezpieczeństwa i odpowiedniej legislacji. Podmiotem sprawy są zarówno obywatele, jak i środowisko przedsiębiorców. Na horyzoncie tych działań widać również pilne zapotrzebowanie na określenie zasad etycznych. Jedną z najpilniejszych potrzeb jest ponadto ustanowienie struktury zarządzania na poziomie europejskim i krajowym. Nowo określone ramy prawne umożliwiają ocenę modeli sztucznej inteligencji, egzekwowanie od ich dostawców transparentności oraz nakładanie sankcji.

Oprócz oczywistych korzyści, jakich możemy spodziewać się po potencjale AI, Europejczycy muszą być świadomi ryzyka. Ustawa o sztucznej inteligencji określa aplikacje, takie jak gry wideo z obsługą AI czy filtry spamu jako obciążone minimalnym ryzykiem. Aktualnie systemy stosowane w UE należą do bezpiecznych.

Rozpoznanie skali zagrożenia

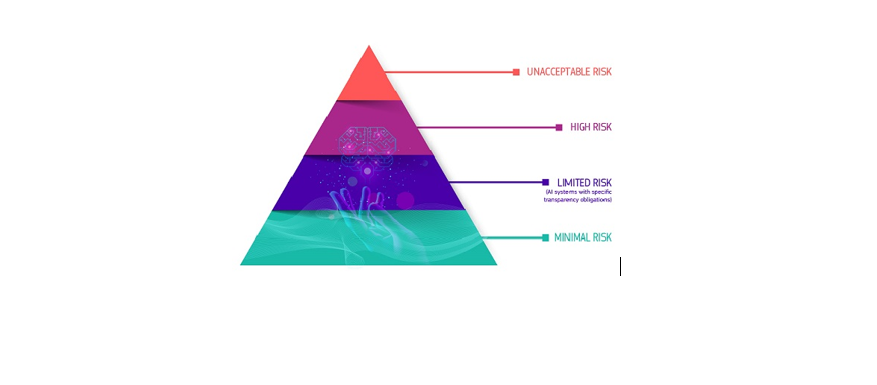

AI Act to pionierski, unijny akt o sztucznej inteligencji, który przepisy opiera na analizie ryzyka. Wyróżniono w nim 4 poziomy ryzyka:

Systemy sztucznej inteligencji uznane za zagrożenie dla bezpieczeństwa, środków utrzymania i podstawowych praw ludzi będą nielegalne. Co może być niedozwolone? – Wszystko: od punktacji społecznej przez rządy do zabawek.

W konsekwencji systemy sztucznej inteligencji zidentyfikowane jako te z obszaru wysokiego ryzyka będą podlegać ścisłym obowiązkom weryfikacyjnym przed praktycznym zastosowaniem. W tym kontekście przyjrzyjmy się np. systemom zdalnej identyfikacji biometrycznej. To one zostaną objęte radykalną kontrolą i są zasadniczo zabronione. Regulacje prawne dopuszczą korzystanie ze wspomnianej technologii jedynie w przypadkach takich jak: realne zagrożenie terrorystyczne, poszukiwanie dziecka czy groźnego przestępcy. Wówczas potrzebne będzie zezwolenie sądowe oraz wytyczne co do przestrzeni i czasu zastosowania.

Ograniczone ryzyko to brak przejrzystości w stosowaniu sztucznej inteligencji i dotyczy chociażby chatbotów. W tym miejscu wydaje się oczywiste, że każdy obywatel musi wiedzieć, kiedy rozmawia z maszyną. To właśnie omawiana ustawa zapewni ludziom, że dostawcy usługi będą identyfikować treści generowane przez sztuczną inteligencję poprzez odpowiednie oznakowanie. Ma to istotne znaczenie zwłaszcza w przypadku treści tzw. deepfake. Generowanie fałszywych treści stanowi jedno z najpoważniejszych zagrożeń cyberbezpieczeństwa. Obecnie cyberprzestępcy inwestują w tę technologię, aby podnosić skuteczność kampanii socjotechnicznych oraz wyłudzać pieniądze.

Ustawa o sztucznej inteligencji umożliwia swobodne stosowanie sztucznej inteligencji o minimalnym ryzyku. Obejmuje to aplikacje, takie jak gry wideo z obsługą AI lub filtry spamu. Zdecydowana większość systemów sztucznej inteligencji stosowanych obecnie w UE należy do tej kategorii.

Europejski Urząd ds. Sztucznej Inteligencji

W lutym br. powołano w ramach Komisji urząd, którego zadaniem jest egzekwowanie ustawy o sztucznej inteligencji. Jako wartości określono: poszanowanie godności człowieka, prawo i zaufanie. Biuro ma także stanowić ośrodek wsparcia dla innowacji, współpracy i badań w dziedzinie AI. W perspektywie globalnej urząd przewiduje konieczność wypracowania wspólnej drogi do zarządzania sztuczną inteligencją. Europejski Urząd ds. AI ma szansę wypromować Europę jako lidera w etycznym i kontrolowanym rozwoju technologii AI, jeśli skutecznie wypracuje jednolity europejski system zarządzania.

Ustawa o AI wejdzie w życie 20 dni po jej opublikowaniu w Dzienniku Urzędowym. W pełni stosowana będzie 2 lata później, ale zakazy wejdą w życie po sześciu miesiącach. Podstawowe zasady zarządzania i obowiązki dotyczące modeli sztucznej inteligencji ogólnego przeznaczenia staną się obligatoryjne po upływie 12 miesięcy. Ramy prawne dotyczące systemów sztucznej inteligencji – wbudowane w produkty regulowane – muszą być respektowane po 36 miesiącach. Aby nie tracić cennego czasu, Komisja Europejska przygotowała także dobrowolną inicjatywę „Pakt na rzecz sztucznej inteligencji” – mającą na celu wsparcie wdrażania przepisów. Motywuje twórców AI z Europy i nie tylko – do respektowania fundamentalnych zobowiązań określonych w Akcie AI, zanim wejdą w życie.

- Źródło:

- https://digital-strategy.ec.europa.eu/pl/policies/regulatory-framework-ai

- Europejski Urząd ds. Sztucznej Inteligencji | Kształtowanie cyfrowej przyszłości Europy (europa.eu)

Kowalczyk, ISW, Fot.